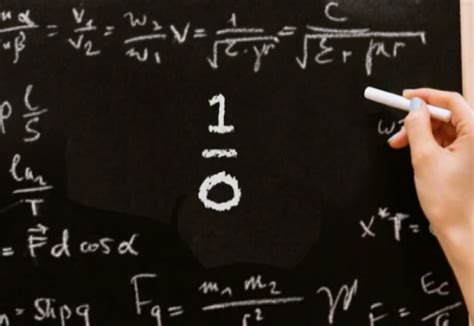

Деление на ноль – это одна из самых спорных и сложных тем в математике. Возможность, или скорее невозможность, деления на ноль вызывает множество вопросов и дискуссий среди ученых.

Давайте разберемся, что означает деление на ноль и почему оно вызывает столь большой интерес.

В основе математики лежат некоторые фундаментальные правила, и одно из них утверждает, что число умноженное на ноль равно нулю. Но что будет, если попытаться разделить число на ноль?

Одной из важнейших особенностей математики является аксиома уникальности обратного элемента. То есть для каждого числа существует такое число, умноженное на которое оно будет равно единице. Но как быть в случае с нулем? Умножение нуля на какое бы число ни было никогда не приведет к единице.

Ноль в математике

Однако, в математике существует некоторые ограничения и особенности, связанные с нулем. Например, нельзя поделить любое число на ноль. Это правило называется "запретом деления на ноль". Попытка деления на ноль приводит к неопределенности и противоречиям в математических выражениях и уравнениях.

Для более точной работы с нулем и предотвращения неопределенности, в математике были разработаны особые правила. Например, при умножении на ноль любого числа получается сам ноль. Еще одно интересное правило - ноль возвышенный в нулевую степень равняется единице.

Ноль играет важную роль не только в арифметике, но и в других областях математики, таких как алгебра, геометрия и анализ. Он используется для определения некоторых особых свойств и решений в этих областях. Например, ноль является нейтральным элементом в операции сложения и вычитания.

| Операция | Результат |

| N + 0 | N |

| N - 0 | N |

Ноль также играет важную роль в математических системах и формулах, где используется линейная алгебра и матрицы. Например, нулевой вектор является важным понятием в линейной алгебре и используется для описания некоторых свойств и операций с векторами.

Таким образом, ноль является основным числом и символом в математике. Он обладает уникальными свойствами и играет важную роль в различных математических операциях и концепциях.

Сложности при делении на ноль

Если попытаться выполнить деление на ноль, возникают различные проблемы. Во-первых, такая операция не имеет определения в математике, поэтому невозможно получить точный результат. Во-вторых, она приводит к ошибкам и противоречиям в вычислениях.

Деление на ноль может привести к получению бесконечности или неопределенности. Например, если разделить число на ноль, можно получить результат "бесконечность", а если поделить ноль на ноль, результат будет неопределенным.

Также деление на ноль может привести к возникновению противоречивых высказываний. Например, если в уравнении используется деление на ноль, можно получить несостоятельность уравнения.

В целом, деление на ноль является неприемлемой операцией в математике. Использование такой операции может привести к непредсказуемым и некорректным результатам. Поэтому в математике принято считать деление на ноль недопустимой операцией.

Что происходит при делении на ноль?

При попытке выполнить деление на ноль, математические правила и определения перестают работать. Результат такого деления невозможно точно вычислить, поскольку не существует числа, которое можно умножить на ноль и получить другое число.

В некоторых математических дисциплинах и областях, таких как математический анализ или теория функций, возможно рассмотрение пределов и асимптотического поведения функций при приближении к нулю. Однако общепринятого значения или результата деления на ноль в арифметике нет.

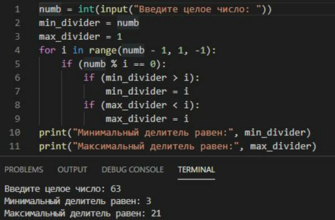

Деление на ноль может привести к ошибкам в вычислениях и программировании. При попытке выполнить деление на ноль в компьютерных программах, обычно происходит генерация исключительной ситуации или ошибки, чтобы предотвратить некорректное поведение или неверные результаты.

Важно помнить, что деление на ноль не является допустимой операцией в обычной арифметике и требует особого внимания в математических вычислениях и программировании.