В мире обработки естественного языка невозможно обойтись без токенайзеров. Токенизация - это процесс разделения текста на отдельные слова или фразы, называемые токенами. Токенизаторы используются во многих приложениях, от поисковых систем до машинного обучения.

В этом руководстве мы рассмотрим основы создания своего собственного токенайзера. Мы покажем, как разделить текст на токены, учитывая особенности каждого языка и задачи обработки.

Начнем с базовым принципов токенизации: мы разделим текст на слова, игнорируя пунктуацию и пробелы. Для этого мы будем использовать регулярные выражения, которые позволяют упростить процесс токенизации.

В качестве основного языка программирования мы будем использовать Python, так как он предлагает мощные инструменты для работы с текстом и регулярными выражениями. Однако, вы можете адаптировать эти идеи к любому другому языку программирования, поддерживающему регулярные выражения.

Что такое токенайзер

Токенайзер играет важную роль в обработке текста, поскольку он помогает разбить длинный и сложный текст на более мелкие и понятные части, которые могут быть легко обработаны алгоритмами или другими методами анализа данных. Токенайзер может выполнять такие задачи, как удаление пунктуации, приведение всех слов к нижнему регистру, удаление стоп-слов и другие преобразования, в зависимости от требований конкретной задачи.

В современных программных библиотеках и фреймворках для обработки текста, таких как NLTK, SpaCy или TensorFlow, доступны готовые токенайзеры, которые можно легко использовать в своих проектах. Тем не менее, понимание принципов работы токенайзера и возможность создания собственного токенайзера являются важными навыками для анализа и обработки текста.

Зачем нужен токенайзер

Токенизация текста важна для множества приложений NLP. В процессе обработки текста токенайзер разделяет текст на отдельные единицы, токены, чтобы анализировать их отдельно или совместно с другими токенами. Это помогает в решении таких задач, как разбор предложений, определение частей речи, вычисление статистики, детектирование именованных сущностей и многое другое.

Токенизация текста имеет свою значимость в разработке алгоритмов машинного обучения и искусственного интеллекта. Токены облегчают преобразование текстовых данных в числовой формат, который может быть использован для обучения моделей машинного обучения. Также токенизация является важной частью предварительной обработки данных в NLP, помогая уменьшить шум и предобработать текст перед непосредственным анализом.

Токенайзеры реализуются с использованием различных подходов и алгоритмов, включая правила на основе регулярных выражений, правила на основе грамматики, машинное обучение и т. д. Правильный выбор токенайзера может значительно улучшить точность и эффективность анализа текста, учитывая специфику и предпочтения задачи или задач, с которыми работаете.

Примеры применения токенайзера:

Токенизация текста в социальных медиа: Разделение текста пользовательских сообщений на отдельные слова или символы может помочь в анализе настроений или тематики сообщений, выявлении ключевых слов и прогнозировании поведения пользователей.

Автоматическая классификация текста: Токенизация в сочетании с алгоритмами машинного обучения может использоваться для классификации текста по заданным категориям. Например, обработка и классификация новостных статей по теме, тональности или рекламному содержанию.

Машинный перевод: В задачах машинного перевода, токенизация текста является ключевым этапом процесса. Текст обрабатывается и разбивается на отдельные единицы, после чего машинная модель переводит их на другой язык.

Автоматическая суммаризация текста: Разделение текста на отдельные предложения или фразы помогает в создании автоматизированных систем суммаризации текста. Токены могут быть использованы для идентификации ключевых слов, фраз или предложений в тексте.

Токенайзеры широко применяются в различных областях, включая информационный поиск, анализ социальных сетей, обработку естественного языка, машинное обучение и другие. Они позволяют эффективно обрабатывать текст и использовать его в дальнейшем анализе и обучении моделей. Знание и понимание принципов работы токенайзера поможет в освоении различных задач обработки естественного языка и анализа текста.

Шаги создания токенайзера

Для создания токенайзера необходимо выполнить следующие шаги:

| Шаг | Описание |

|---|---|

| Шаг 1 | Определить цель создания токенайзера. Определить, для каких задач вам необходим токенайзер и какие типы токенов вам нужно распознавать. |

| Шаг 2 | Изучить доступные библиотеки и фреймворки для создания токенайзеров. Выбрать наиболее подходящую для ваших целей. |

| Шаг 3 | Собрать тренировочный набор данных для обучения токенайзера. Включите разнообразные примеры текста, которые вы хотите распознать. |

| Шаг 4 | Обучить токенайзер на тренировочном наборе данных с использованием выбранной библиотеки или фреймворка. |

| Шаг 5 | Проверить работу токенайзера на тестовом наборе данных. Оценить точность распознавания токенов и внести необходимые корректировки. |

| Шаг 6 | Протестировать токенайзер на реальных данных и оценить его производительность. Внести доработки при необходимости. |

| Шаг 7 | Документировать созданный токенайзер, включая описание его возможностей и использования. |

| Шаг 8 | Интегрировать токенайзер в ваше приложение или систему. |

| Шаг 9 | Поддерживать и обновлять токенайзер по мере необходимости. |

Следуя этим шагам, вы сможете создать собственный токенайзер, который подходит для ваших конкретных потребностей.

Выбор языка программирования

Определиться с выбором языка программирования можно, учитывая несколько факторов:

- Цели и задачи: определите, для чего вам нужен язык программирования, какие задачи вы хотите решать. Например, некоторые языки больше подходят для разработки веб-приложений, другие - для научных вычислений.

- Сложность: учтите, что некоторые языки программирования сложнее в освоении, чем другие. Если вы новичок, может быть полезно начать с более простых языков, таких как Python или JavaScript.

- Популярность и сообщество: популярные языки программирования обычно имеют большое и активное сообщество разработчиков, что может быть полезно для получения поддержки и обмена опытом.

- Экосистема: учтите наличие готовых библиотек, инструментов и фреймворков для выбранного языка программирования. Наличие широкой экосистемы значительно упрощает разработку приложений.

Изучение языка программирования - это постоянный процесс, поэтому не бойтесь экспериментировать и пробовать новые языки. Выберите язык, который вам нравится, соответствует вашим целям и задачам, и начинайте свое путешествие в мир программирования!

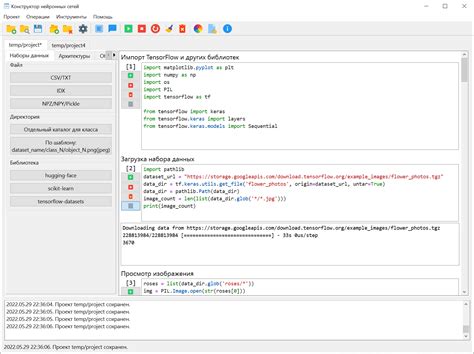

Импорт необходимых библиотек

Перед тем, как начать создавать токенайзер, вам понадобится импортировать необходимые библиотеки. Ниже приведен список библиотек, которые вам понадобятся для работы:

| Библиотека | Описание |

|---|---|

| nltk | Библиотека для обработки естественного языка (Natural Language Processing). |

| string | Библиотека, содержащая набор строковых констант и утилитные функции для работы со строками. |

| re | Модуль для работы с регулярными выражениями в Python. |

Вы можете импортировать эти библиотеки с помощью следующего кода:

import nltk

import string

import re

Теперь вы готовы начать создавать токенайзер и работать с текстовыми данными!

Разработка логики токенайзера

1. Анализ текста: Первым шагом будет анализировать входной текст и разбивать его на отдельные слова, фразы или символы. Для этого можно использовать различные подходы, такие как разделение по пробелам или использование регулярных выражений.

2. Создание правил: Для каждого типа токена вам необходимо создать правила, которые определяют его формат и характеристики. Например, если вам нужен токен, представляющий дату, вы можете определить правила для различных форматов даты (например, "дд.мм.гггг" или "месяц, число, год").

3. Токенизация: После создания правил можно приступить к фактической токенизации текста с использованием разработанных правил. В процессе токенизации текст проходит через эти правила, и каждая соответствующая часть текста распознается и преобразуется в токен.

4. Обработка токенов: После получения токенов вы можете приступить к их обработке в соответствии с вашими потребностями. Например, вы можете анализировать токены для извлечения информации или классификации текста.

5. Тестирование и отладка: Важным этапом является тестирование и отладка вашего токенайзера. Вы можете использовать различные примеры текста и проверять, правильно ли он разделяет текст на токены и соответствует правилам.

Разработка логики токенайзера - процесс, требующий внимания к деталям и тщательного анализа требований к вашему приложению. С использованием правильной логики, вы сможете эффективно обрабатывать текст и извлекать из него необходимую информацию.

Удачи в вашем путешествии в создание токенайзера!

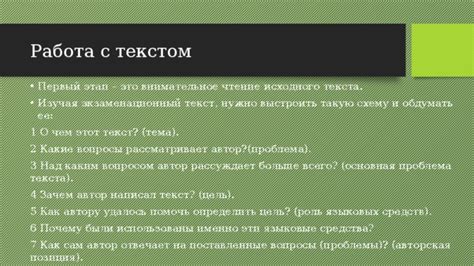

Чтение исходного текста

Прежде чем мы начнем создавать токенайзер, нам необходимо иметь исходный текст, который мы будем анализировать. В этом разделе мы рассмотрим, как можно прочитать и загрузить исходный текст для дальнейшей обработки.

Существует несколько способов получить исходный текст. Один из них - использовать файловую систему и загрузить текстовый файл соответствующим образом. Этот подход особенно удобен, если у вас уже есть исходный текст в текстовом файле.

Для загрузки текстового файла вы можете использовать файловые операции с помощью языка программирования, которым вы пользуетесь. Например, в Python вы можете использовать следующий код:

filename = "исходный_текст.txt"

with open(filename, 'r', encoding='utf-8') as file:

text = file.read()

В этом примере мы открываем файл с именем "исходный_текст.txt" в режиме чтения ('r'), указывая кодировку UTF-8. Затем мы считываем содержимое файла и сохраняем его в переменную "text".

Если у вас нет исходного текста в текстовом файле, вы можете просто присвоить переменной "text" значение самого исходного текста. Например:

text = "Это пример исходного текста, который мы будем анализировать."

Теперь, когда у нас есть исходный текст, мы можем перейти к созданию токенайзера.

Разделение текста на токены

Существует несколько подходов к разделению текста на токены. Один из самых простых способов - использование пробелов в качестве разделителей. В этом случае каждое слово будет считаться отдельным токеном. Однако такой подход не всегда эффективен, особенно если в тексте содержатся знаки пунктуации, числа или специальные символы.

Более сложные алгоритмы разделения текста на токены используются в различных библиотеках и фреймворках для обработки естественного языка. Например, в библиотеке NLTK (Natural Language Toolkit) для языка Python есть готовые токенизаторы, которые могут разбивать текст на слова или предложения. Токенизаторы могут учитывать контекстные особенности языка, например, различные правила для аббревиатур или дефисов.

При разделении текста на токены важно учитывать особенности конкретной задачи и языка, на котором написан текст. Например, в некоторых случаях может потребоваться сохранять знаки пунктуации или объединять некоторые слова в один токен (например, составные слова или имена собственные).

Важно также помнить, что разделение текста на токены - это лишь первый шаг обработки текста, который может потребоваться в более сложных задачах, таких как анализ тональности, определение ключевых слов или машинный перевод. Для этих задач могут потребоваться дополнительные преобразования и обработка текста после токенизации.

Обработка токенов

После того как были получены токены с помощью токенизатора, приходит время их обработать.

Варианты обработки токенов могут включать в себя:

- Удаление стоп-слов

- Стемминг или лемматизация

- Удаление пунктуации и специальных символов

- Нормализация регистра

- Извлечение ключевых слов

Удаление стоп-слов - это процесс удаления наиболее часто встречающихся слов в языке, которые обычно не несут смысловой нагрузки, таких как "а", "и", "или".

Стемминг и лемматизация - это процессы, которые сводят слово к его основной форме. Например, слова "играю", "играл" и "играющий" после стемминга или лемматизации будут приведены к слову "играть".

Удаление пунктуации и специальных символов может быть полезным, если они не являются релевантной информацией для исследуемого текста.

Нормализация регистра - это процесс приведения всех слов к нижнему или верхнему регистру. Это позволяет избежать проблем с учетом разных вариантов написания одних и тех же слов.

Извлечение ключевых слов может быть полезным для дальнейшего анализа текста, позволяя выделить наиболее важные и информативные слова или фразы.

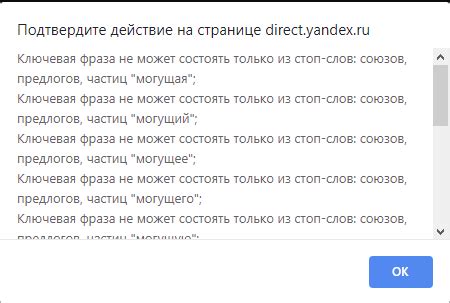

Исключение стоп-слов

Использование стоп-слов может существенно повлиять на качество и точность анализа текста. Удаление исключительно нерелевантных слов позволяет сосредоточиться на ключевых словах и фразах, которые действительно несут смысловую нагрузку.

В процессе создания токенизатора можно включать или исключать определенные слова из списка стоп-слов в зависимости от конкретной задачи. Например, для анализа текстов научных статей можно исключить общие слова, так как они несут мало информации о содержании статьи.

Для исключения стоп-слов можно воспользоваться готовыми списками, которые доступны для различных языков. Эти списки обычно включают наиболее распространенные стоп-слова. Однако, в некоторых случаях может потребоваться создание собственного списка стоп-слов, исходя из специфики анализируемого текста.

При создании токенизатора и исключении стоп-слов рекомендуется также учитывать семантическую связь слов. Некоторые слова могут иметь разные формы и варианты, но все равно нести схожую смысловую нагрузку. Такие слова тоже следует исключить из анализа, чтобы не дублировать информацию.

| а | без | в | во | вы | да | для | до | если | же |

| за | и | из | или | к | ко | как | ли | на | не |

| ни | но | о | об | от | по | под | при | с | со |

| у | что | это | этот | я |