Огибающая – это график, который отражает наибольшую амплитуду колебаний некоторого сигнала. Найти огибающую может быть полезно во многих областях, таких как сигнальная обработка, анализ данных, музыкальные инструменты и многое другое. Однако, чтобы успешно найти огибающую, необходимо знать основные способы и алгоритмы.

Одним из самых простых и распространенных способов поиска огибающей является метод скользящего окна. Данный метод заключается в том, что сначала сигнал разбивается на фрагменты заданной длины, а затем для каждого фрагмента находится его максимальное значение. Таким образом, мы получаем набор точек, которые образуют огибающую. Этот метод прост в реализации и дает достаточно хорошие результаты для многих задач.

Еще одним распространенным алгоритмом поиска огибающей является алгоритм Хэллоуинта. Он основан на использовании фильтра нижних частот и состоит из двух этапов. На первом этапе сигнал фильтруется нижним фильтром, чтобы удалить высокочастотные компоненты. На втором этапе к отфильтрованному сигналу применяется операция модуляции, чтобы найти огибающую. Алгоритм Хэллоуинта обладает хорошей адаптивностью к различным типам сигналов и шуму, поэтому он широко используется в многих приложениях.

Понятие и цель

Основная цель нахождения огибающей - найти главные характеристики набора кривых, такие как максимумы, минимумы и точки перегиба. Огибающая помогает упростить и аппроксимировать сложные совокупности данных, которые изначально содержали множество деталей.

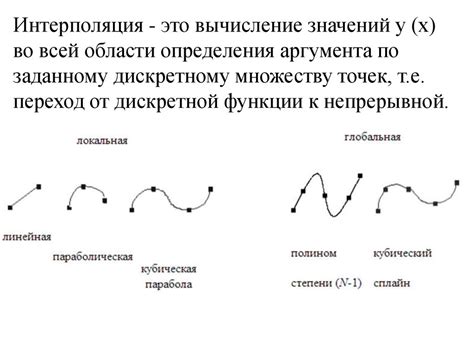

Интерполяция

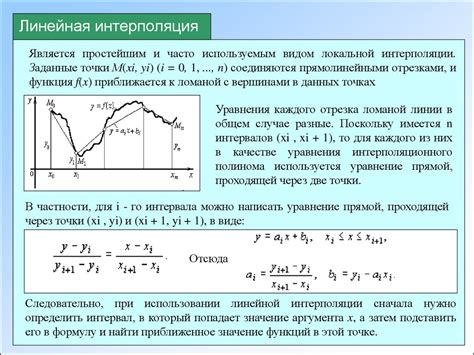

Существует несколько основных алгоритмов интерполяции:

- Линейная интерполяция: Простейший метод, основанный на предположении, что между двумя заданными точками лежит прямая. Формула для нахождения промежуточных значений:

y = y1 + (y2 - y1) * ((x - x1) / (x2 - x1)). - Полиномиальная интерполяция: Сложный метод, использующий полиномы для нахождения аппроксимации. Основная идея заключается в нахождении полинома, который проходит через все заданные точки.

- Сплайн-интерполяция: Метод, использующий сплайны - гладкие кусочно-полиномиальные функции, проходящие через заданные точки. Сплайн-интерполяция создает более плавные и естественные кривые, чем другие методы.

Для выбора наиболее подходящего алгоритма интерполяции необходимо учитывать особенности и характеристики данных. Некоторые алгоритмы могут быть более точными, но требовать большего количества вычислительных ресурсов, тогда как другие могут быть более эффективными с точки зрения времени выполнения.

Интерполяция широко используется в различных областях, таких как компьютерная графика, наука о данных, физика, финансы и др. Правильный выбор метода интерполяции помогает получить более точные и реалистичные результаты в этих областях.

Аппроксимация

В аппроксимации можно использовать различные алгоритмы и методы. Например, метод наименьших квадратов позволяет минимизировать сумму квадратов разностей между исходными данными и аппроксимирующей функцией. Другой популярный метод - интерполяция, где используется полиномиальная модель для построения аппроксимации.

Выбор метода аппроксимации зависит от типа данных и требуемой точности. Некоторые алгоритмы лучше подходят для дискретных данных, в то время как другие эффективны при аппроксимации непрерывных функций. Также стоит учитывать, что некоторые методы могут быть чувствительны к выбросам или шуму в данных.

Аппроксимация широко используется в различных областях, включая математику, физику, экономику, статистику и компьютерную графику. Она является мощным инструментом для анализа данных и построения моделей.

Линейная регрессия

Основная идея линейной регрессии заключается в поиске оптимальной линии, которая наилучшим образом описывает зависимость между независимыми и зависимыми переменными. Для этого используется метод наименьших квадратов, который минимизирует сумму квадратов разностей между фактическими и предсказанными значениями.

Процесс построения линейной регрессии включает несколько шагов:

- Сбор данных: для построения модели необходимо собрать данные о зависимых и независимых переменных.

- Подготовка данных: данные обычно требуется очистить и преобразовать для улучшения качества модели.

- Выбор модели: в зависимости от типа данных и задачи выбирается подходящая модель линейной регрессии.

- Обучение модели: на основе подготовленных данных происходит обучение модели наиболее подходящим методом, например, методом наименьших квадратов.

- Оценка модели: после обучения модели ее необходимо оценить на основе различных метрик, таких как R-квадрат и среднеквадратическая ошибка.

- Применение модели: после успешной оценки модели она может быть использована для предсказания новых значений зависимой переменной.

Линейная регрессия может быть применена к различным типам задач, например, одномерной регрессии, где только одна независимая переменная используется для предсказания, или множественной регрессии, где несколько независимых переменных используются вместе.

Ключевым преимуществом линейной регрессии является ее простота и интерпретируемость результатов. Однако стоит отметить, что линейная регрессия имеет свои ограничения и может быть не подходящей для задач с нелинейной зависимостью между переменными.

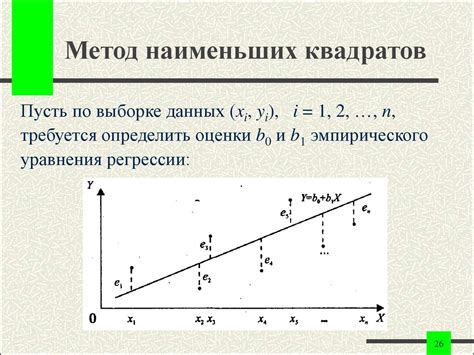

Метод наименьших квадратов

Принцип работы метода наименьших квадратов заключается в минимизации суммы квадратов отклонений между экспериментальными значениями и значениями, которые предсказывает модель. Для этого огибающая кривая выбирается таким образом, чтобы сумма квадратов отклонений была минимальна.

Метод наименьших квадратов позволяет находить огибающую кривую для различных типов функций: линейных, полиномиальных, экспоненциальных и т.д. Кроме того, этот метод также может использоваться для поиска огибающей в нелинейных системах уравнений.

Одним из преимуществ метода наименьших квадратов является его простота и эффективность. Он имеет математическую основу и может быть реализован с помощью различных алгоритмов и программных пакетов. Благодаря этому, МНК широко применяется в различных областях науки и техники, таких как физика, экономика, биология и другие.

Однако стоит отметить, что метод наименьших квадратов имеет некоторые ограничения. Например, он может быть неэффективен, если данные содержат выбросы или шумы. Кроме того, в случае нелинейных зависимостей между переменными, МНК может давать неточные результаты. В таких случаях требуются более сложные методы аппроксимации и поиска огибающей.

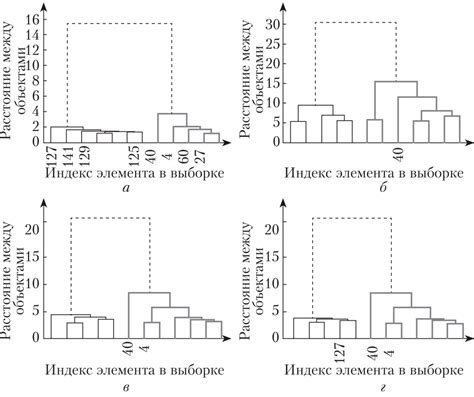

Метод иерархической кластеризации

Основная идея метода заключается в последовательном объединении ближайших кластеров до достижения заданного условия остановки. Этот критерий может быть задан заранее с помощью требуемого числа кластеров или с помощью заданного уровня сходства.

Иерархическая кластеризация может быть проведена с использованием различных алгоритмов. Некоторые из наиболее распространенных алгоритмов включают:

- Алгоритм одиночной связи (Single Linkage). Он объединяет два кластера на основе минимального расстояния между их ближайшими объектами.

- Алгоритм полной связи (Complete Linkage). Он объединяет два кластера на основе максимального расстояния между их самыми удаленными объектами.

- Алгоритм средней связи (Average Linkage). Он объединяет два кластера на основе среднего расстояния между их объектами.

- Алгоритм центроидов (Centroid Linkage). Он объединяет два кластера на основе расстояния между их центроидами.

Выбор конкретного алгоритма зависит от природы данных и поставленной задачи. Каждый алгоритм имеет свои преимущества и недостатки, и его выбор может оказать значительное влияние на результаты кластеризации.

В результате иерархической кластеризации получается дендрограмма, которая представляет собой дерево, отображающее иерархию кластеров. Дендрограмма может быть использована для определения оптимального числа кластеров или для визуализации структуры данных.

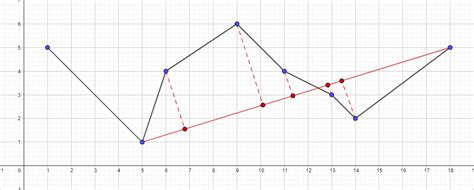

Алгоритм Дугласа-Пекера

Основная идея алгоритма заключается в сокращении количества точек на кривой, сохраняя при этом ее общую форму. Алгоритм Дугласа-Пекера работает следующим образом:

- Выбирается начальная и конечная точка кривой.

- Находится точка из кривой, наиболее удаленная от прямой, проходящей через начальную и конечную точки.

- Если данная точка находится дальше заданного порогового значения, она добавляется к огибающей. Если нет, то она отбрасывается.

- Далее происходит рекурсивный вызов алгоритма для двух полученных отрезков, от начальной точки до добавленной и от добавленной точки до конечной.

Алгоритм Дугласа-Пекера может быть использован для упрощения любых кривых, представленных в виде множества точек.

Одно из преимуществ этого алгоритма заключается в его эффективности. Он позволяет сократить количество точек на кривой до необходимого уровня детализации, что может быть особенно полезно при визуализации и анализе больших объемов данных.

Кроме того, алгоритм Дугласа-Пекера сохраняет общую форму кривой, поэтому он является хорошим выбором при работе с геометрическими данными, где важна сохранность формы объекта.

Анализ точек перегиба

Анализ точек перегиба обычно проводится для определения характеристик кривой, таких как выпуклость или вогнутость. Знание положения точек перегиба позволяет прогнозировать поведение кривой в различных точках.

Существует несколько способов анализа точек перегиба, один из которых - нахождение второй производной функции и анализ ее знака. Если вторая производная меняет знак при переходе через точку, то она считается точкой перегиба.

Также существует метод анализа точек перегиба с использованием кривизны и освещенности точки. Этот метод позволяет определить, на какой стороне кривой находится точка перегиба и ее степень.

Анализ точек перегиба является важным шагом в исследовании огибающих кривых и позволяет получить дополнительную информацию о их поведении. Зная положение и характер точек перегиба, можно лучше понять структуру кривой и прогнозировать ее поведение.