В настоящее время задачи классификации и сегментации являются неотъемлемой частью анализа данных. Одним из наиболее распространенных методов для решения данных задач является кластеризация. Данный алгоритм позволяет группировать объекты схожие по своим характеристикам и формировать перекрывающиеся или неперекрывающиеся кластеры.

В рамках данной статьи мы рассмотрим один из самых популярных алгоритмов кластеризации - k-means. Этот метод основывается на идее минимизации среднеквадратичного отклонения между объектами и центроидами кластеров. Он активно применяется во многих областях, таких как машинное обучение, компьютерное зрение, анализ социальных сетей и т.д.

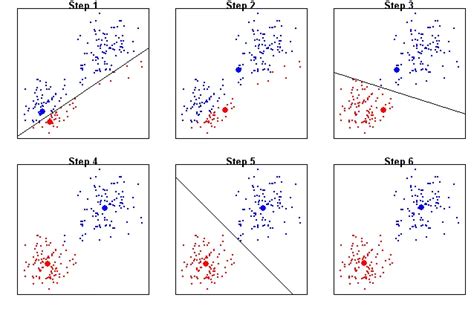

Принцип работы алгоритма заключается в итеративном разбиении объектов на заранее заданное количество кластеров. Первоначально выбираются случайные центроиды, которые являются представителями кластеров. Затем каждый объект присваивается к тому кластеру, центроид которого находится ближе всего к нему. После этого каждый центроид пересчитывается путем вычисления среднего значения характеристик всех объектов, принадлежащих к данному кластеру. Процесс повторяется до сходимости или до достижения максимального числа итераций.

Результатом работы алгоритма является разбиение объектов на кластеры таким образом, чтобы внутри каждого кластера объекты были как можно более похожи между собой, а объекты из разных кластеров - различались. Полученные кластеры могут быть использованы для дальнейшего анализа данных, поиска выбросов, выявления закономерностей и принятия решений.

Основные принципы кластеризации с использованием алгоритма k-средних

Сущность метода k-средних

В этом разделе рассмотрим ключевые элементы кластеризации при помощи алгоритма k-средних. Представим основные идеи этого метода без глубокого технического описания. Проанализируем, как он осуществляет группировку данных и чем его особенности отличаются от других алгоритмов кластеризации.

Выбор кластеров и их представителей

Один из ключевых шагов алгоритма k-средних – определение количества кластеров и выбора их представителей. Мы разберем методы выбора начальных центроидов и аргументированно объясним, почему именно такой подход используется в данном методе. Кроме того, поговорим о важности правильной инициализации и о влиянии начального выбора на результаты кластеризации.

Итеративный процесс сходства и перерасчета

Следующим шагом кластеризации с использованием алгоритма k-средних является итеративный процесс. Мы рассмотрим этот процесс более подробно и объясним, как происходит перерасчет центроидов и присвоение точек к новым кластерам. Также обратим внимание на влияние выбора расстояния между точками на результаты кластеризации.

Остановка и оценка качества кластеризации

Правильное определение момента остановки и оценка качества полученных кластеров являются важными задачами. Мы обсудим различные подходы к оценке качества кластеризации и рассмотрим критерии, такие как сумма квадратов расстояний и внутрикластерное расстояние. Также представим возможные проблемы и подводные камни, которые могут возникнуть при использовании алгоритма k-средних.

Преимущества и ограничения метода k-средних

Шаги алгоритма k means

- Инициализация:

- Задается количество кластеров k, которое мы хотим образовать из набора данных.

- Случайным образом выбираются k точек из набора данных в качестве начальных центроидов каждого кластера.

- Каждый объект из набора данных присваивается к ближайшему центроиду (кластеру) на основе выбранной метрики расстояния, например, евклидова.

- Пересчитываются координаты центроидов каждого кластера путем усреднения координат всех объектов, принадлежащих данному кластеру.

- Проверяется выполнение критерия остановки, который может быть связан с минимальным изменением центроидов или иными характеристиками качества кластеризации.

- Если критерий остановки не выполнен, то повторяются шаги 2-4, то есть объекты снова присваиваются кластерам и пересчитываются центроиды. Этот процесс продолжается до достижения критерия остановки.

Таким образом, алгоритм k-means основывается на итеративном присвоении объектов кластерам и обновлении центроидов в каждой итерации. Результатом работы алгоритма является разбиение набора данных на определенное количество кластеров с минимизацией внутрикластерного разброса и максимизацией межкластерного различия.

Выбор оптимального числа кластеров в алгоритме k-means

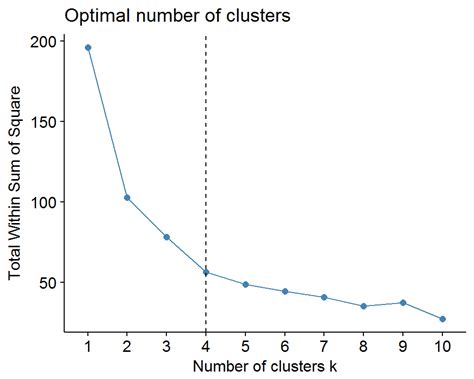

При применении алгоритма k-means для кластеризации данных необходимо определить оптимальное число кластеров. Этот выбор играет ключевую роль в точности и интерпретируемости результатов.

Один из подходов к выбору числа кластеров основан на анализе суммарного расстояния от каждой точки данных до центроидов соответствующих кластеров. По мере увеличения числа кластеров, это расстояние будет уменьшаться. Однако, при дальнейшем увеличении числа кластеров, улучшение уменьшения расстояния будет замедляться. Выбор оптимального числа кластеров связан с поиском такого значения, после которого уменьшение суммарного расстояния становится незначительным.

Существует несколько методов для определения оптимального числа кластеров. Один из них - метод локтя. Он основывается на наблюдении за изменением суммарного расстояния при разном числе кластеров. Визуализация этих данных в виде графика, привлекает внимание на форме графика, которая напоминает сгиб на локте. Точка этого сгиба соответствует оптимальному числу кластеров.

Кроме того, можно использовать критерий информационной сложности. Он основан на оценке сложности модели с учетом уровня детализации, которое достаточно сохранить для передачи исходных данных. Таким образом, оптимальное число кластеров будет соответствовать точке баланса между точностью кластеризации и уровнем детализации.

| Метод | Принцип | Преимущества | Недостатки |

|---|---|---|---|

| Метод локтя | Анализ суммарного расстояния | Прост в реализации, нагляден | Не всегда определяет точку локтя однозначно |

| Критерий информационной сложности | Оценка сложности модели | Учитывает баланс точности и детализации | Требует дополнительных вычислений |

Методы и метрики для оценки качества кластеризации с использованием алгоритма k-means

Одним из основных методов оценки качества кластеризации является внутренний и внешний индексы. Внутренний индекс оценивает однородность и компактность кластеров внутри либо степень сходства объектов внутри одного кластера. Внешний индекс, в свою очередь, оценивает разделение между различными классами или кластерами. Метрики позволяют сравнить результаты кластеризации с истинными или предоставленными метками, чтобы оценить точность и эффективность алгоритма k-means.

- Индекс Дэвиса-Боулдина: данный индекс позволяет оценить разделяющую способность кластеров и определить оптимальное количество кластеров, основываясь на средних значениях внутрикластерного и межкластерного расстояний.

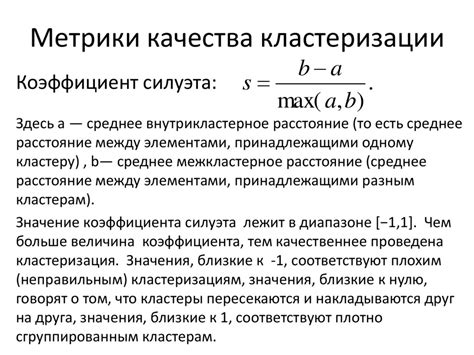

- Силуэт: метрика силуэта может быть использована для оценки качества разбиений и помогает определить оптимальное количество кластеров. Она учитывает внутрикластерное расстояние и расстояние до ближайшего кластера для каждого объекта.

- Индекс Коэна: данный индекс основывается на вероятности правильной классификации объектов и позволяет сравнить результаты кластеризации с известными метками.

Кроме того, существуют и другие методы и метрики, такие как коэффициент силуэта, индекс Рендера, индекс Жаккара и многие другие, которые также помогают в оценке качества кластеризации. Выбор конкретного метода или метрики зависит от специфики задачи и требований исследования.

Применение кластеризации методом k means в реальной задаче: примеры использования алгоритма

Одним из примеров применения алгоритма k means является сегментация клиентов интернет-магазина. Представим, что у нас есть данные о покупках клиентов, и мы хотим выделить группы клиентов схожих по своим покупкам и поведению. С помощью k means мы можем разделить всех клиентов на кластеры, где клиенты внутри одного кластера будут иметь похожий профиль потребления. Например, это могут быть клиенты, предпочитающие модную одежду, или клиенты, интересующиеся электроникой. Это позволит магазину настраивать персонализированные рекомендации и предложения для каждого кластера клиентов, увеличивая тем самым конверсию и продажи.

Еще одним примером применения k means может быть анализ социальных сетей. Предположим, у нас есть информация о пользователях соцсети - их возраст, пол, местоположение и предпочтения в музыке. С помощью алгоритма k means мы можем разделить пользователей на группы схожих интересов и поведения, что позволит лучше понять целевую аудиторию, настроить таргетированную рекламу, а также предлагать пользователям релевантный контент и подходящих друзей или группы.

Таким образом, кластеризация методом k means имеет множество практических применений и может быть использована в различных областях для группировки объектов по их схожести. С помощью этого алгоритма можно получить ценную информацию о данных, находя закономерности и выявляя скрытые группы, что позволяет принимать взвешенные решения, опираясь на анализ данных.

Вопрос-ответ

Как работает кластеризация методом k means?

Кластеризация методом k-means начинается с случайного выбора k центроидов, где k - это предварительно заданное количество кластеров. Затем каждая точка данных присваивается к ближайшему центроиду. После этого происходит перераспределение центроидов путем вычисления новых средних значений точек данных в каждом кластере. Этот процесс повторяется до тех пор, пока центроиды не стабилизируются и кластеризация не сойдется.

Как выбрать правильное количество кластеров для метода k-means?

Определение правильного количества кластеров для метода k-means может быть сложной задачей. Существует несколько подходов, включая метод локтя и метод силуэта. Метод локтя заключается в построении графика, где по оси x отображается количество кластеров, а по оси y - среднее расстояние между точками данных и центроидом в каждом кластере. Затем можно выбрать количество кластеров, где среднее расстояние перестает значительно снижаться после каждой итерации. Метод силуэта оценивает качество кластеризации, учитывая, насколько данные хорошо разделены внутри каждого кластера и насколько они отличаются от других кластеров. Используя эти методы, можно принять более обоснованное решение о количестве кластеров для метода k-means.

Какой алгоритм используется для решения проблемы локального минимума в методе k-means?

В методе k-means одной из проблем является возможность застрять в локальном минимуме, когда алгоритм не может найти лучшие центроиды для кластеризации. Для таких случаев существует несколько подходов. Один из них - запуск k-means несколько раз с разными начальными центроидами и выбор наилучшего результата. Другой подход - использование модификаций метода k-means, таких как k-means++, которые изменяют начальное положение центроидов для повышения шансов нахождения глобального минимума. Также можно использовать алгоритмы с использованием эвристических методов, которые помогают избежать проблемы локального минимума.

Can the k-means clustering algorithm handle categorical data?

No, the k-means clustering algorithm is primarily designed for continuous numerical data. It calculates the mean of each cluster, which doesn't make sense for categorical variables. In order to cluster categorical data, other algorithms such as k-modes or k-prototypes can be used. These algorithms take into account the different nature of categorical variables and have specific methods for clustering them.